感觉坑越挖越大,慢慢填~~~~

继续上篇进行填坑,这一篇我们介绍下循环神经网络

目录

3.2. 循环神经网络(RNN)

3.2.1. 算法形成过程

3.2.2. 运行原理

3.2.3. RNN有哪些优缺点

3.2.4. RNN参数

3.2.5. 如何选择RNN模型参数

3.2.6. 算法简单示例

3.2.7. 梯度消失/爆炸问题

3.2.8. 反向传播算法(BPTT)

3.2. 循环神经网络(RNN)

循环神经网络(Recurrent Neural Network, RNN)是一类用于处理序列数据的神经网络。

3.2.1. 算法形成过程

循环神经网络的形成过程主要基于对传统神经网络结构的扩展,以适应序列数据的处理需求。

其关键特点在于网络中的循环连接,使得信息能够在网络中循环传递。

RNN的基本结构包括输入层、隐藏层和输出层,其中隐藏层具有循环连接,能够捕获并记忆序列中的时间依赖关系。

3.2.2. 运行原理

RNN的运行原理可以归纳为以下几点:

序列输入:RNN接受一系列有序的输入数据,如时间序列、文本序列等。

循环连接:RNN的隐藏层之间存在循环连接,使得网络能够维护一个“记忆”状态。这个状态包含了过去的信息,使RNN能够理解序列中的上下文信息。

时间步迭代:在每个时间步,RNN都会根据当前的输入和上一个时间步的隐藏状态来计算新的隐藏状态。这个过程会沿着序列依次进行,形成信息的循环传递。

输出:在每个时间步,RNN都可以产生一个输出,这个输出可以基于当前的隐藏状态计算得出。对于某些任务,如文本生成,RNN的输出可以直接作为下一个时间步的输入。

训练与优化:RNN的训练通常使用反向传播算法(Backpropagation Through Time, BPTT)来优化网络参数。通过最小化预测值与真实值之间的误差来更新网络权重。

3.2.3. RNN有哪些优缺点

优点:

处理序列数据能力强:RNN天然适合处理序列数据,如文本、时间序列等。由于其循环连接的结构,RNN能够捕捉序列中的时间依赖关系,从而在处理具有时序特性的数据时表现出色。

记忆能力:RNN具有记忆先前信息的能力,这使得它在处理需要上下文信息的任务时非常有用。例如,在机器翻译中,RNN能够记住源语言句子的前面部分,从而帮助生成更准确的翻译。

参数共享:RNN在每个时间步都使用相同的参数,这使得模型更加简洁且易于训练。参数共享还减少了模型需要学习的参数数量,有助于防止过拟合。

动态性:RNN可以处理变长的输入序列,这使得它在处理不同长度的数据时具有很大的灵活性。

缺点:

梯度消失/爆炸问题:在训练过程中,RNN可能会遇到梯度消失或梯度爆炸的问题。当序列长度较长时,梯度在反向传播过程中可能会逐渐消失(变得非常小),导致模型难以学习到长距离依赖关系;或者梯度可能会急剧增大(爆炸),导致模型训练不稳定。

计算效率低:由于RNN需要按时间步顺序处理输入序列,因此它不能并行化计算。这限制了RNN在处理大规模数据集时的计算效率。

难以捕捉长期依赖:尽管RNN具有一定的记忆先前信息的能力,但在实践中,它往往难以捕捉到非常长期的依赖关系。这可能是因为梯度消失问题以及RNN结构的局限性。

训练难度:RNN的训练可能比其他类型的神经网络更加困难,特别是当涉及到长序列时。需要仔细调整学习率、初始化参数等超参数以获得良好的训练效果。

为了解决RNN的这些缺点,研究者们提出了许多改进方案,如LSTM(长短期记忆网络)和GRU(门控循环单元)等变体结构,它们通过引入门控机制和记忆单元来改进RNN的性能,特别是在处理长序列和捕捉长期依赖方面取得了显著进展。(我怎么又在给自己挖坑-.-bbbbbb)

3.2.4. RNN参数

RNN模型参数主要包括以下几类,我将分点表示并进行归纳:

- 输入层参数:

- 词嵌入层参数:当处理文本数据时,RNN通常需要一个词嵌入层将离散的词语转换为连续向量。这包括词汇表的大小(vocab_size)和词向量的维度(embedding_dim)。

- 序列长度参数(seq_length):表示输入序列的长度。不同的任务可能需要不同长度的输入序列。

- 输入层维度参数(input_dim):表示输入序列的维度,即每个时间步的输入特征的维度。

- 隐含层参数:

- 隐含层维度参数(hidden_dim):即RNN隐含层的维度,也就是隐含层状态的维度。这个参数的选择对模型的表达能力和表示能力有着重要影响。

- 隐含层类型参数(cell_type):表示RNN隐含层的类型,如简单RNN(SimpleRNN)、长短期记忆网络(LSTM)和门控循环单元(GRU)等。不同类型的隐含层具有不同的记忆能力和建模能力。

- 隐含层层数参数(num_layers):表示RNN模型中隐含层的层数。增加层数可以提高模型的复杂度,但也可能增加过拟合的风险。

- 其他参数:

- 非线性激活函数:如tanh、ReLU等,用于增加网络的非线性表达能力。

- 偏置(bias):表示是否在模型中使用偏置项,通常默认为True。

- batch_first:如果为True,则输入和输出的第一个维度将是batch size。

- dropout:表示在层之间的dropout概率,用于防止过拟合。

- 双向RNN(bidirectional):表示是否为双向RNN,双向RNN可以同时考虑序列的前后信息。

这些参数的选择对RNN模型的性能有着至关重要的影响。在实际应用中,通常需要通过实验来确定最佳的参数组合。此外,当使用深度学习框架(如PyTorch或TensorFlow)实现RNN时,还可以根据框架提供的API来调整和优化这些参数。

3.2.5. 如何选择RNN模型参数

选择RNN模型参数是一个关键步骤,它直接影响模型的性能和训练效果。以下是选择RNN模型参数的具体步骤:

1. 确定隐藏层大小

- 隐藏层神经元数量:隐藏层大小指的是RNN模型中隐藏层的神经元数量。这个参数的选择对模型的容量和性能有重要影响。

- 选择方法:可以通过交叉验证或网格搜索等方法来尝试不同的隐藏层大小,并选择在验证集上表现最好的大小。较小的隐藏层可能会导致模型容量不足,难以捕捉序列中的复杂关系;而较大的隐藏层可能会导致模型过拟合。

2. 设置学习率

- 学习率的作用:学习率决定了模型在每次参数更新时的步长大小,对模型的训练速度和稳定性有重要影响。

- 选择方法:一种常见的做法是从一个较大的学习率开始训练,然后逐渐减小学习率,以帮助模型更好地收敛。此外,还可以使用学习率调度器(如指数衰减、余弦退火等)来自动调整学习率。

3. 确定迭代次数

- 迭代次数的定义:迭代次数指的是训练过程中模型遍历整个数据集的次数。

- 选择方法:迭代次数应根据数据集的大小、模型的复杂度和训练时间等因素来综合确定。过多的迭代次数可能导致训练时间过长,而过少的迭代次数可能导致模型未能充分学习数据的特征。

4. 选择激活函数

- 激活函数的作用:激活函数为模型引入非线性,使得RNN能够学习到复杂的模式。

- 常见选择:在RNN中,常见的激活函数包括tanh和ReLU等。选择合适的激活函数可以提高模型的表达能力和训练效率。

5. 考虑正则化技术

- 正则化的目的:为了防止模型过拟合,可以考虑使用正则化技术,如L1正则化、L2正则化或dropout等。

- 实施方法:这些技术可以在训练过程中添加到模型中,以提高模型的泛化能力。

6. 监控验证集性能

- 重要性:在训练过程中,应始终监控模型在验证集上的性能。

- 调整参数:如果发现模型在验证集上的性能下降或出现波动,应及时调整上述参数以优化模型性能。

选择RNN模型参数是一个迭代和优化的过程。通过不断地尝试和调整,可以找到最适合当前任务和数据集的参数组合。

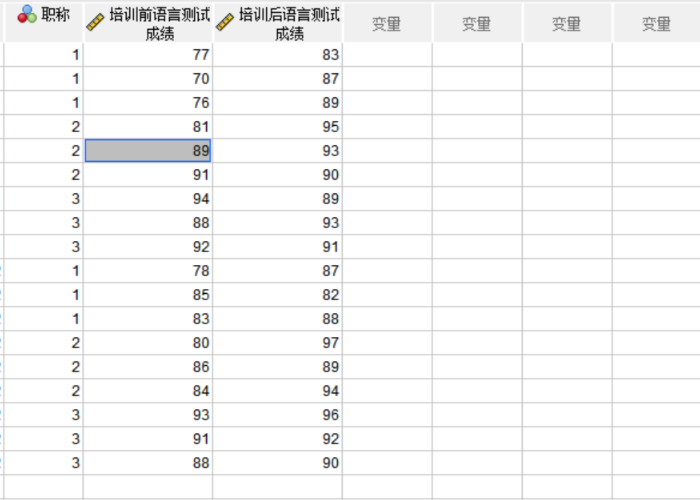

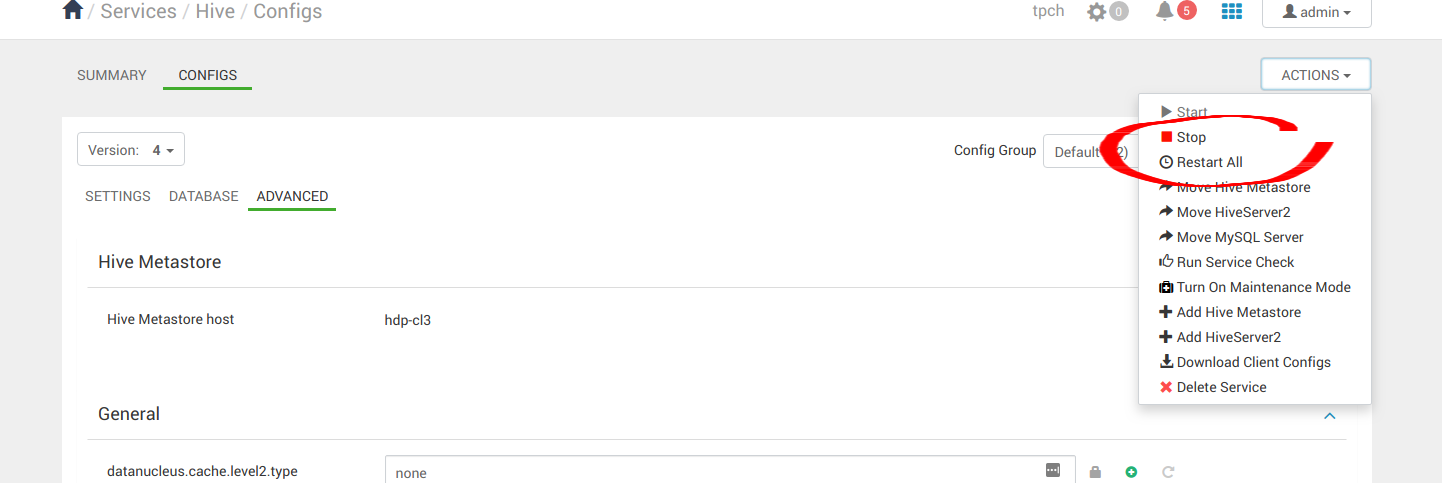

3.2.6. 算法简单示例

Python示例

以下是一个简单的RNN实现示例,使用TensorFlow框架:

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import SimpleRNN, Dense

# 定义RNN模型

model = Sequential()

model.add(SimpleRNN(50, input_shape=(None, 1))) # 隐藏层有50个单元,输入形状为(时间步长, 特征数)

model.add(Dense(1)) # 输出层有1个单元

# 编译模型

model.compile(optimizer='adam', loss='mse')

# 假设我们有一些训练数据

import numpy as np

x_train = np.random.random((100, 10, 1)) # 100个样本,每个样本10个时间步,每个时间步1个特征

y_train = np.random.random((100, 1)) # 100个样本的输出

# 训练模型

model.fit(x_train, y_train, epochs=10, batch_size=32)C++示例

在C++中实现RNN通常需要使用专门的机器学习库,如TensorFlow C++ API。以下是一个简化的示例框架,展示如何在C++中使用TensorFlow来实现RNN(请注意,这只是一个框架示例,具体实现细节可能因TensorFlow版本和具体任务而异):

#include "tensorflow/core/public/session.h"

#include "tensorflow/core/platform/env.h"

using namespace tensorflow;

int main() {

// 初始化TensorFlow会话

Session* session;

Status status = NewSession(SessionOptions(), &session);

if (!status.ok()) { /* 处理错误 */ }

// 加载已经训练好的RNN模型(此处为伪代码)

GraphDef graph_def;

status = ReadBinaryProto(Env::Default(), "path/to/your/model.pb", &graph_def);

if (!status.ok()) { /* 处理错误 */ }

status = session->Create(graph_def);

if (!status.ok()) { /* 处理错误 */ }

// 准备输入数据(此处为伪代码)

Tensor input_tensor(DT_FLOAT, TensorShape({1, 10, 1}));

// 填充input_tensor数据...

// 运行RNN模型进行推断

std::vector<Tensor> outputs;

status = session->Run({{"input_placeholder", input_tensor}}, {"output_tensor"}, {}, &outputs);

if (!status.ok()) { /* 处理错误 */ }

// 处理输出结果

// ...

// 清理资源

session->Close();

delete session;

return 0;

}请注意,C++中的实现通常更加复杂,需要处理更多的底层细节。上述C++示例主要是为了展示如何在TensorFlow C++ API中加载模型和处理数据的基本流程。实际应用中,你需要根据自己的模型和数据进行相应的调整。

由于C++实现RNN涉及较多底层细节和TensorFlow C++ API的复杂使用,通常建议先在Python环境中进行模型的开发和调试,然后再考虑将模型导出为可在C++环境中使用的格式(如TensorFlow的SavedModel格式),最后在C++中进行加载和使用。

3.2.7. 梯度消失/爆炸问题

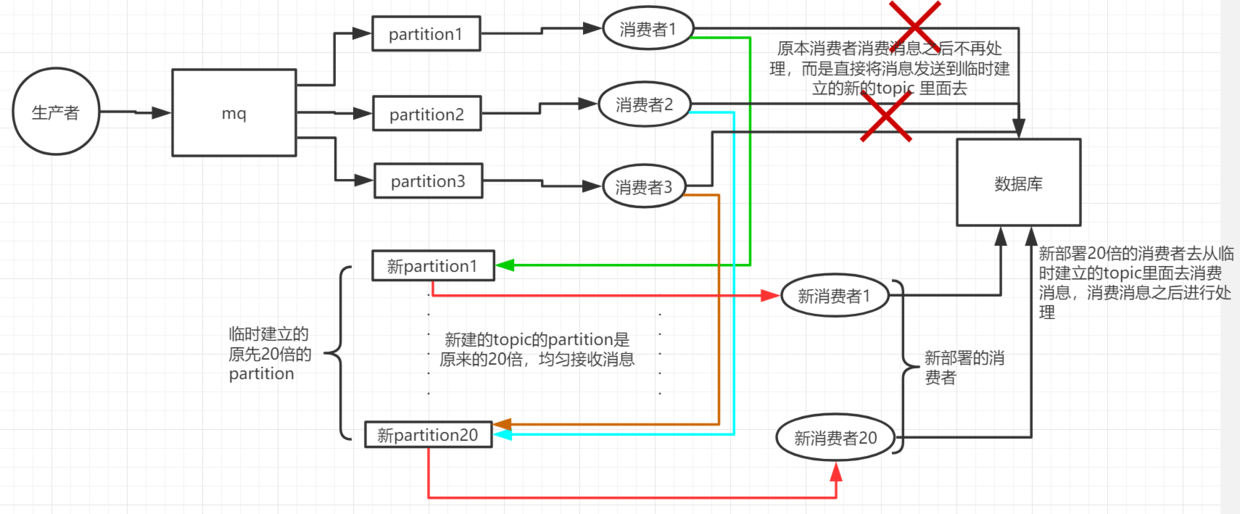

在RNN算法中,梯度消失和梯度爆炸是两个常见的问题,它们主要发生在反向传播过程中。

梯度消失产生原因:

- 网络层次过深:在深层RNN中,误差需要通过多层网络进行反向传播。如果每一层的梯度都小于1,随着层数的增加,梯度会呈指数级衰减,最终导致梯度几乎为零。这种情况下,网络无法有效地更新权重,难以学习到长距离依赖关系。

- 激活函数选择不当:某些激活函数(如sigmoid和tanh)的导数在大部分定义域内都较小。例如,sigmoid函数的导数最大值仅为0.25。在链式求导过程中,这些小导数会相乘,导致梯度迅速减小。

梯度爆炸产生原因:

- 权重初始化值过大:在深度神经网络中,如果初始权重过大,反向传播时的梯度可能会变得非常大。

- 网络结构问题:在某些网络结构中,层与层之间的梯度如果大于1并且重复相乘,梯度可能会以指数级增长。

常规解决方法

为了解决RNN中的梯度消失和梯度爆炸问题,可以采取以下策略:

选择合适的激活函数:使用如ReLU等激活函数,其导数在较大范围内保持较大值,有助于缓解梯度消失问题。

权重初始化方法:采用合适的权重初始化方法,如He初始化或Xavier初始化,以避免初始权重过大导致的梯度爆炸。

使用正则化技术:例如批归一化(Batch Normalization),可以帮助控制梯度的规模,减少梯度消失或爆炸的风险。

采用LSTM或GRU结构:这些特殊的RNN结构通过引入门控机制和记忆单元来更好地处理序列数据,从而有效缓解梯度消失和梯度爆炸问题。LSTM模型中的遗忘门、输入门和输出门协同工作,控制信息的流动和记忆的更新,使得模型能够更好地捕捉长期依赖关系。

梯度裁剪:通过设置梯度阈值,防止梯度在反向传播过程中过大增长,从而避免梯度爆炸。

3.2.8. 反向传播算法(BPTT)

RNN(循环神经网络)的训练通常使用反向传播算法(Backpropagation Through Time, BPTT)的一个变体。由于RNN处理的是序列数据,其反向传播算法需要沿着时间步进行,因此被称为“通过时间的反向传播”。在BPTT中,网络的输出误差会沿着时间反向传播,通过每个时间步,以更新网络的权重。

Python示例代码(使用PyTorch)

在Python中,使用PyTorch框架可以很方便地实现RNN的反向传播训练。以下是一个简单的示例:

import torch

import torch.nn as nn

import torch.optim as optim

# 定义一个简单的RNN模型

class SimpleRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(SimpleRNN, self).__init__()

self.rnn = nn.RNN(input_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

out, _ = self.rnn(x)

out = self.fc(out[:, -1, :])

return out

# 模型参数和超参数

input_size = 1

hidden_size = 10

output_size = 1

learning_rate = 0.01

num_epochs = 100

# 创建模型实例、损失函数和优化器

model = SimpleRNN(input_size, hidden_size, output_size)

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=learning_rate)

# 创建一些模拟数据和标签

x = torch.randn(1, 5, input_size) # 假设序列长度为5

y = torch.randn(1, output_size) # 假设输出维度为1

# 训练模型

for epoch in range(num_epochs):

# 前向传播

outputs = model(x)

loss = criterion(outputs, y)

# 反向传播和优化

optimizer.zero_grad() # 清空梯度

loss.backward() # 反向传播

optimizer.step() # 更新权重

# 打印损失

if (epoch+1) % 10 == 0:

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item()}')C++示例代码(使用LibTorch)

在C++中,使用LibTorch(PyTorch的C++ API)也可以实现RNN的训练。以下是一个简单的示例:

#include <torch/torch.h>

#include <iostream>

// 定义模型(与前面的Python示例相似)

struct SimpleRNNImpl : torch::nn::Module {

// ...(与前面的C++示例相同)

};

TORCH_MODULE(SimpleRNN);

int main() {

// 初始化、模型定义等(与前面的C++示例相同)

// ...

// 定义优化器和损失函数

torch::optim::SGD optimizer(model->parameters(), torch::optim::SGDOptions(0.01));

auto criterion = torch::nn::MSELoss();

// 模拟数据和标签

torch::Tensor x = torch::randn({1, 5, input_size});

torch::Tensor y = torch::randn({1, output_size});

// 训练模型

for (int epoch = 0; epoch < num_epochs; ++epoch) {

optimizer.zero_grad();

// 前向传播

torch::Tensor outputs = model->forward(x);

torch::Tensor loss = criterion(outputs, y);

// 反向传播

loss.backward();

// 更新权重

optimizer.step();

// 打印损失

if ((epoch + 1) % 10 == 0) {

std::cout << "Epoch [" << epoch + 1 << "/" << num_epochs << "], Loss: " << loss.item() << std::endl;

}

}

return 0;

}这两个示例展示了如何使用PyTorch和LibTorch来训练一个简单的RNN模型。注意,在实际应用中,你可能需要处理更复杂的数据集、调整模型架构和超参数,并添加其他训练技巧(如早停、正则化等)以优化模型性能。

先写到这里,后面慢慢聊~~~

![[创业之路-129] :制造业企业的必备管理神器-ERP-生产制造](https://img-blog.csdnimg.cn/direct/d661435cbde74b50bed4d310096e2bce.png)